在数字化浪潮下,企业数据正呈现 “爆炸式增长” 与 “碎片化分布” 并存的态势。销售订单、库存台账、财务报表、客户画像等数据分散在不同业务系统,格式各异、标准不一,形成了一道道 “数据壁垒”。想要让这些数据发挥价值,就需要一个核心枢纽来打通壁垒、整合资源 —— 数据集成平台正是为此而生,它不仅是数据的 “搬运工”,更是企业数字化转型的 “赋能者”。

一、重新认识数据集成平台:不止是 “整合工具”

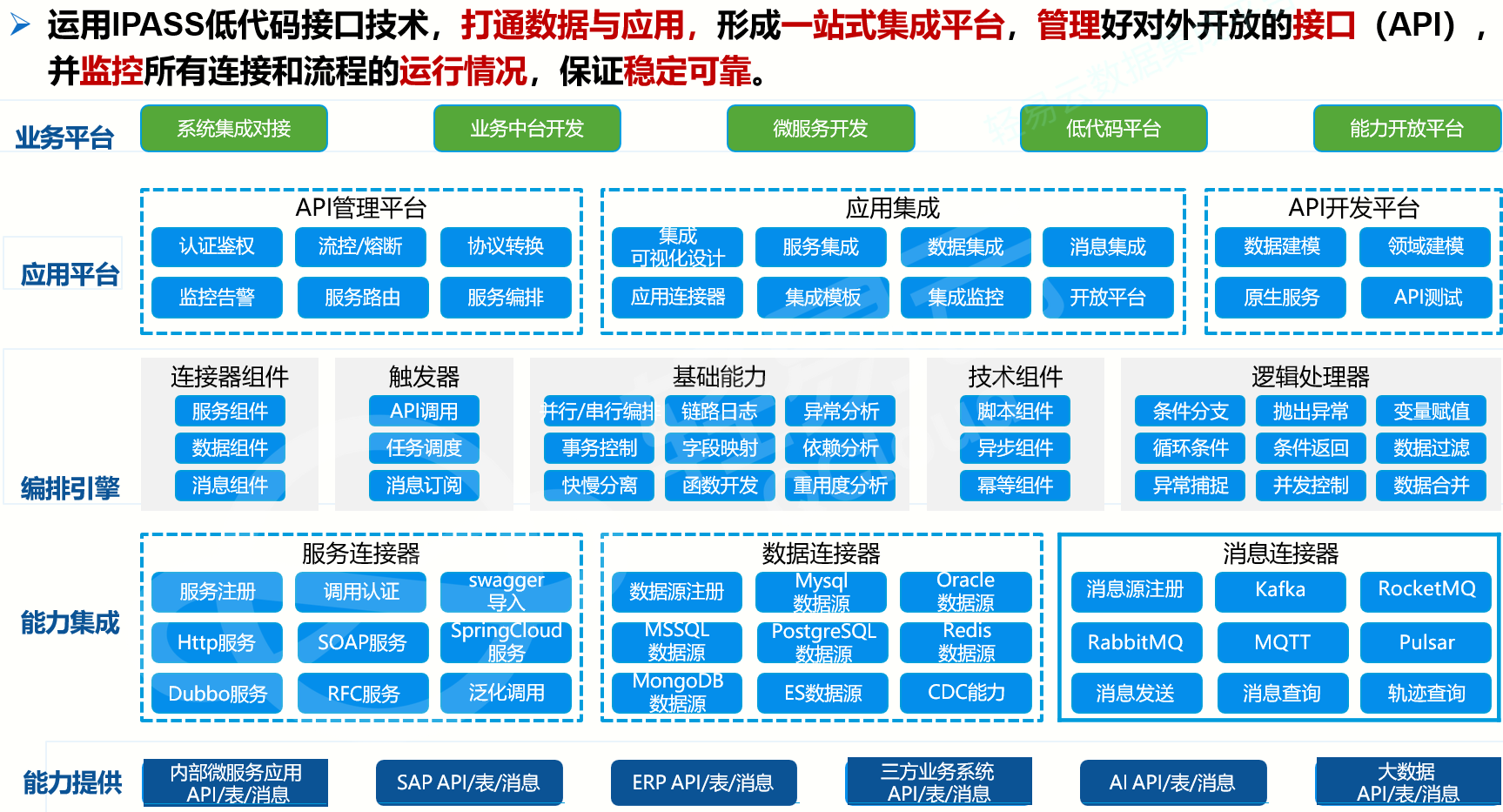

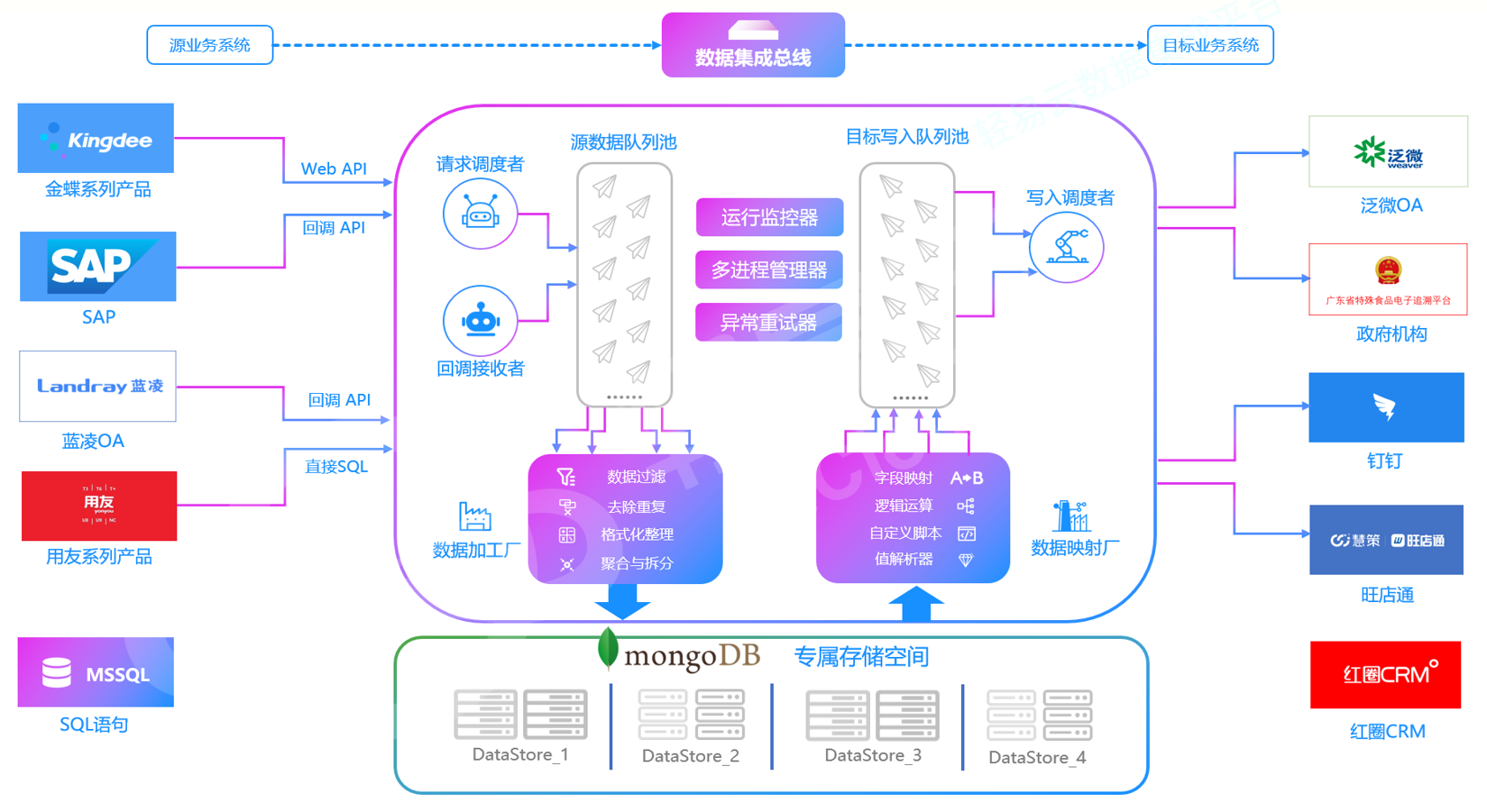

数据集成平台的核心定位,是企业数据流转的 “中央处理器”。它通过标准化技术流程,实现跨系统、跨格式、跨存储的数据采集、规整与分发,让原本孤立的数据形成互联互通的 “数据生态”。

不同于简单的数据复制工具,它具备三大核心特质:

兼容性覆盖全场景:无论是传统关系型数据库(MySQL、Oracle)、新型 NoSQL 数据库(MongoDB、Redis),还是 Excel 表格、CSV 文件、云服务数据、物联网传感器数据,都能无缝对接。

处理能力智能化:不仅能完成基础的数据格式转换,还能通过内置算法实现数据清洗、去重、补全、脱敏,让 “脏数据” 变身 “高价值数据”。

流转模式灵活化:支持实时同步、批量处理、定时调度等多种流转方式,适配不同业务对数据时效性的需求。

举个典型案例:某连锁餐饮品牌拥有线下门店 POS 系统、线上外卖平台、供应链管理系统和会员管理系统。没有集成平台时,总部想要分析 “某款新品的区域销售热度与库存匹配度”,需要人工从 4 个系统导出数据,耗时 2 天且易出错。引入数据集成平台后,系统自动采集各渠道销售数据、库存数据和会员消费数据,经过清洗整合后实时同步至分析平台,总部当天就能拿到精准报表,补货决策效率提升 80%。

从技术底层来看,数据集成平台的核心架构围绕 “ETL/ELT” 展开:

提取(Extract):从多源异构数据源中精准采集原始数据,支持全量抽取(适用于初始化、小体量静态数据)和增量抽取(适用于高频更新数据,如电商订单)两种模式。

转换(Transform):核心环节,包括数据清洗(剔除错误、重复记录)、格式标准化(统一日期、金额、编码规则)、业务规则运算(如按区域汇总销售额、计算库存周转率)、冲突修正(按预设规则解决跨系统数据不一致问题)。

加载(Load):将处理后的标准化数据,按需分发至数据仓库、数据湖、BI 分析工具或业务系统,支持实时加载、批量加载(如海量历史数据迁移)、定时加载(如夜间数据汇总)。

二、四大核心功能:解锁数据价值的 “关键抓手”

数据集成平台的价值,集中体现在四大核心功能的协同发力上,每一项功能都直击企业数据管理的痛点:

1. 多源数据抽取:无死角覆盖数据源头

数据抽取是数据集成的 “第一步”,核心目标是 “全面、高效、不遗漏”。

全量抽取:适用于系统初始化、数据量小且更新频率低的场景(如企业组织架构数据),一次性完成全量数据迁移,确保基础数据完整。

增量抽取:针对高频更新数据(如实时订单、用户行为日志),仅采集上次抽取后的新增或变更数据,大幅降低服务器负载和传输成本,提升处理效率。

特色优势:支持断点续传、异常重试机制、补漏机制,避免因网络波动或系统故障导致的数据丢失,保障数据采集的稳定性。

2. 智能数据转换:让数据 “可用、可信”

原始数据往往存在 “格式混乱、信息残缺、逻辑冲突” 等问题,数据转换就是 “数据精加工” 过程:

清洗去噪:自动识别并剔除无效数据(如手机号格式错误、日期超出合理范围)、删除重复记录,通过算法补全缺失值(如用区域平均值填补缺失的销售数据)。

格式统一:将不同系统的 “方言数据” 转化为标准格式,比如把 “YYYY/MM/DD”“MM-DD-YYYY” 统一为 “YYYY-MM-DD”,把不同币种金额换算为统一基准。

业务赋能:根据企业需求进行数据重组与运算,比如将 “产品表” 与 “订单表” 按产品 ID 关联,生成 “产品销售明细表”;基于 “单价 × 销量” 计算 “总营收”,衍生高价值业务字段。

3. 灵活数据加载:适配多样化业务场景

处理后的干净数据,需要精准送达目标系统才能发挥作用,加载功能的核心是 “按需分配、时效匹配”:

实时加载:毫秒级响应数据变更,适用于对时效性要求极高的场景,如库存预警、实时营销推送。

批量加载:累计一定量数据后集中分发,适用于数据量巨大但时效要求较低的场景,如历史数据归档、月度财务数据汇总,可降低系统并发压力。

定时加载:在业务低峰期(如凌晨 0-4 点)按预设计划自动执行加载任务,避免影响核心业务系统运行,适用于日常数据和报表更新等场景。

4. 全链路监控管理:保障数据流转 “稳、准、安”

数据集成不是 “一劳永逸”,全链路的监控与管理是确保系统长期稳定运行的关键:

实时监控:可视化展示数据抽取、转换、加载的进度,实时追踪任务执行状态,清晰呈现数据流转全链路。

异常告警:当出现数据抽取失败、转换报错、加载超时等问题时,通过邮件、短信、系统弹窗等方式即时告警,支持快速定位问题根源。

安全管控:内置数据备份与恢复机制,防止数据丢失;严格的权限管理体系,精准控制不同角色的数据访问权限和操作权限,保障数据安全。

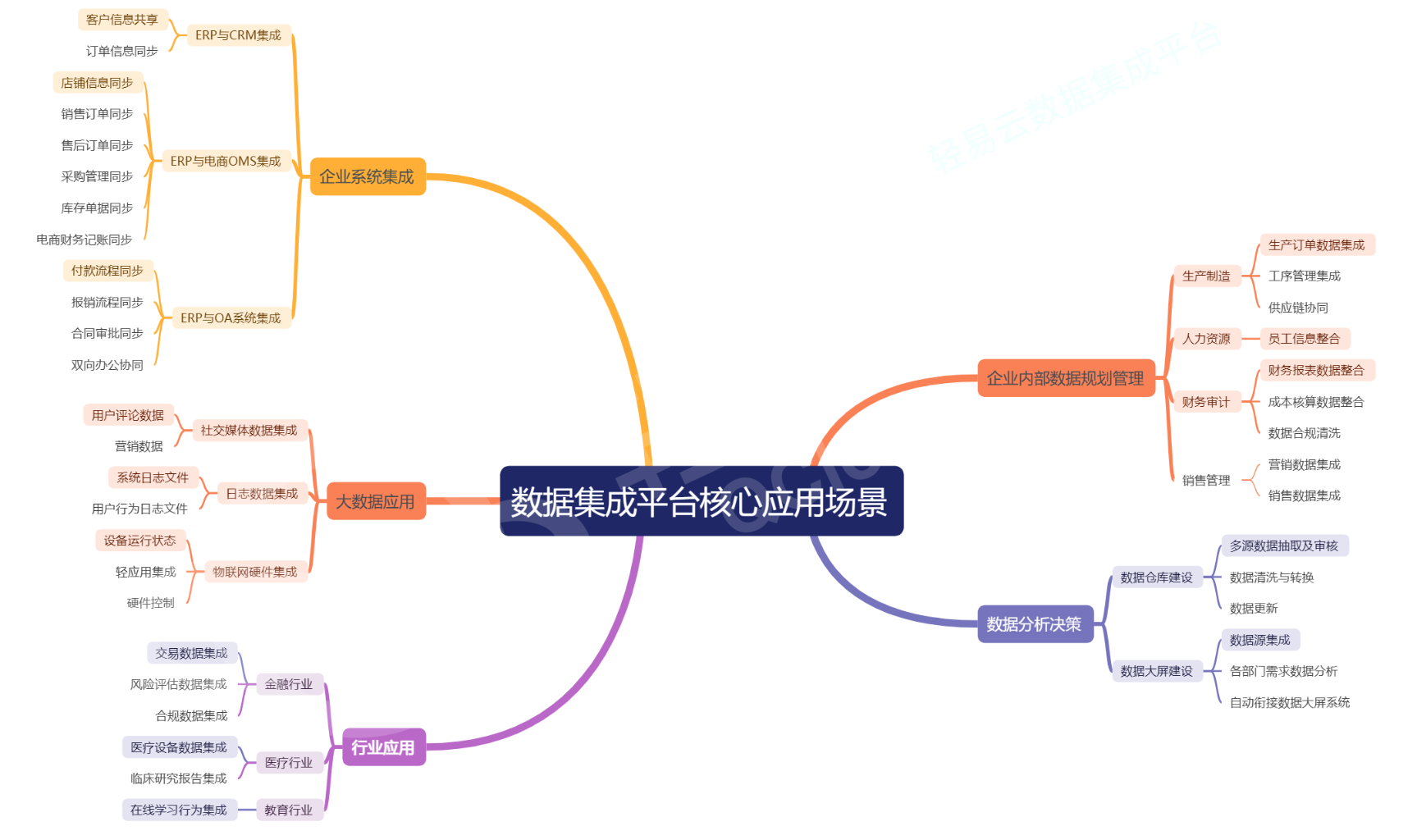

三、五大典型应用场景:数据集成的 “实战价值”

数据集成平台的优势,最终要通过实际业务场景落地体现,以下五大场景最能凸显其核心价值:

1. 支撑精准决策:让数据成为 “决策依据”

企业决策最怕 “数据不全、数据不准”。数据集成平台将销售、财务、生产、供应链等各部门数据整合,形成 “全景式数据视图”。管理层通过 BI 工具分析整合后的数据,可快速掌握销售额趋势、成本结构、库存周转效率等核心指标,避免 “拍脑袋决策”,让战略制定、市场布局、产品迭代更具科学性。

2. 加速数据仓库建设:打造 “数据资产库”

数据仓库是企业存储历史数据、支撑深度分析的核心载体,而数据集成平台是数据仓库的 “奠基者”。它按照数据仓库的架构设计,自动完成数据的抽取、清洗、转换与加载,实现历史数据归档、增量数据更新,确保数据仓库中的数据 “新鲜、一致、可用”。无论是 Teradata 等传统数仓,还是阿里云 AnalyticDB 等云原生数仓,都需要数据集成平台提供稳定的数据输入。

3. 实现系统协同:打破 “信息孤岛”

企业常用的 ERP、CRM、MES、OA 等系统,往往因建设周期、厂商不同而无法直接互通。数据集成平台可搭建系统间的 “数据桥梁”:CRM 系统的客户信息更新后,自动同步至客服系统和售后系统,让服务更精准;MES 系统的生产数据实时同步至 ERP 系统,助力财务部门快速核算成本;OA 系统的审批数据对接业务系统,让流程更顺畅。

4. 赋能大数据应用:释放 “海量数据价值”

大数据时代的 “数据洪流”,需要强大的集成能力作为支撑。数据集成平台可处理 TB 级甚至 PB 级数据,兼容结构化、半结构化(JSON、日志)、非结构化(文本、图片元数据)等多种格式,支持实时流处理。无论是用户行为分析、客户画像构建,还是物联网设备监控、社交媒体舆情分析,都能通过数据集成平台完成数据预处理,为后续的机器学习、深度挖掘提供高质量数据支撑。

5. 适配行业特定需求:定制化数据解决方案

不同行业的数据分析需求存在差异,数据集成平台可针对性适配:

金融行业:整合交易数据、风控数据、合规数据,支持实时风险监测与合规审计。

电商行业:对接国内电商、海外跨境平台的数据,使财务系统跟业务系统进行深度融合。

制造业:集成生产数据、质检数据、供应链数据,优化生产计划与质量管控。

四、常见疑问解答:直击实践痛点

Q1:数据集成平台与数据仓库的核心区别是什么?

数据集成平台的核心是 “数据流转与处理”,负责将分散的数据采集、清洗、转换后分发至目标系统,是 “过程性工具”;数据仓库的核心是 “数据存储与管理”,负责存放经过处理的标准化历史数据,是 “结果性载体”。简单来说,数据集成平台为数据仓库 “输送合格数据”,数据仓库为数据分析 “提供稳定存储”。

Q2:如何解决数据集成中的 “数据冲突” 问题?

数据冲突(如同一客户在不同系统的联系方式不一致)是常见痛点,解决方案分四步:

冲突识别:通过字段比对、逻辑校验,定位冲突数据及涉及字段;

原因分析:排查冲突根源,可能是录入错误、系统规则差异、数据同步延迟等;

规则定义:制定冲突处理标准,如 “以核心业务系统(如 CRM)数据为准”“取最新更新时间的数据”“关键冲突人工审核”;

自动执行:在数据转换阶段,通过平台的规则配置功能,自动完成冲突数据的修正与统一。

Q3:选择数据集成平台时,关键考量因素有哪些?

兼容性:能否覆盖企业现有及未来可能用到的数据源类型;

处理性能:能否支撑企业数据量的增长,处理速度是否满足业务需求;

易用性:是否支持低代码配置,降低技术门槛;

稳定性:是否具备完善的监控、告警、备份机制;

扩展性:能否适配业务变化,支持新增数据源、新处理规则的快速配置。

数据集成平台早已不是简单的 “辅助工具”,而是企业数字化转型的 “核心基础设施”。它通过打破数据孤岛、提升数据质量、优化数据流转效率,让数据从 “沉睡的资源” 变为 “活跃的资产”,为企业的精准决策、效率提升、创新发展提供坚实支撑。无论是中小型企业的数字化起步,还是大型企业的数字化升级,数据集成平台都能发挥不可替代的作用。